IBM crea il primo chip a 2nm: svolta nell’industria dei semiconduttori

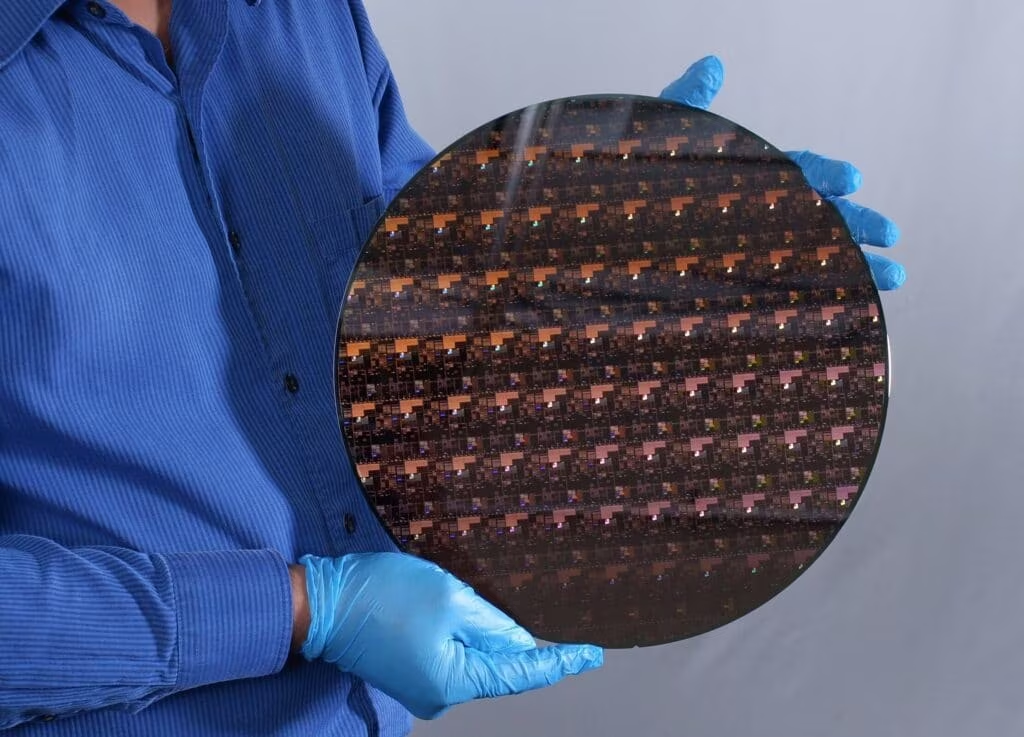

IBM nuovo chip 2nm. Fonte: Notebookcheck

IBM stupisce ancora e annuncia di aver creato un chip a 2nm, il primo con questo processo produttivo. Ad annunciarlo è stata l’azienda stessa con un articolo sul proprio blog, fornendo le prime informazioni sul chip di nuova generazione. L’elaborazione dei dati potrebbe conoscere una rivoluzione non da poco.

IBM: il primo chip a 2nm

Nuovo decennio, nuovo limite della legge di Moore superato. IBM ha annunciato lo sviluppo di un chip a 2nm sfruttando la tecnologia EUV (Extreme Ultra Violet). Questa tecnica di litografia incide un “wafer” di silicio sfruttando un fascio luminoso dell’estremo ultravioletto con lunghezza d’onda di 13.5 nm. La tecnologia ha permesso di incidere chip ancora più piccoli, permettendo di inserirne un numero sempre maggiore sul disco in silicio, aumentando quindi la potenza di elaborazione senza far lievitare i costi di produzione.

Nel caso dell’innovazione IBM si parla di stipare 50 miliardi di transistor su un chip delle dimensioni di un unghia (circa 150mm2 , secondo le indicazioni di IBM). Nelle previsioni dell’azienda la nuova tecnologia porterà un miglioramento delle performance fino al 45% e fino al 75% di energia risparmiata rispetto ai chip 7nm in commercio. Dalle informazioni rilasciate sappiamo che il nuovo processo a 2 nanometri seguirà il design GAA (Gate-All-Around) a 3 livelli, come riportato da AnandTech. La cella ha un’altezza di 75nm e una larghezza di 40nm, mentre i singoli nanosheet sono alti 5nm e sono separati tra loro da altrettanta lunghezza.

Lo sviluppo si è svolto nei laboratori di ricerca IBM di Albany, nello stato di New York. Il complesso, chiamato Albany Nanotech Complex, si trova all’interno dell’istituto politecnico della città che da sempre si occupa delle nanotecnologie in stretta collaborazione con aziende come Samsung e Tokyo Electron. Al momento la tecnologia non è destinata ai dispositivi e viene usata ancora per scopi di test. Sul piatto di silicio ci sono 333 milioni di transistor per millimetro quadrato, pronti ad essere messi sotto stress per valutarne accuratamente le prestazioni.

Il numero “2” nell’indicazione dei nanometri non si riferisce alla sua dimensione, ma al nodo utilizzato per la produzione del chip. Il numero indica il processo utilizzato per lo sviluppo dei chip, esattamente come succedeva per i 10nm, 7nm e 5nm. Non ha quindi nulla a che fare con la grandezza dei transistor o dei chip, ma indica piuttosto la “generazione” tecnologica del processo di produzione. Un numero minore indica un miglioramento in termini di densità dei transistor, misura molto più importante della grandezza.

I benefici della nuova tecnologia

Prestazioni e consumi saranno ottimizzati, superando di molto il chip 5nm, prodotto anch’esso da IBM e utilizzato nei nuovi Mac di prossima uscita, e il 3nm, ancora non commercializzato. I benefici dei nuovi chip coinvolgeranno diversi ambiti e miglioreranno l’elaborazione sotto differenti aspetti. In particolare, IBM riporta che:

- la durata della batteria dei cellulari sarà quadruplicata. I device potranno essere ricaricati ogni 4 giorni (in media);

- diminuirebbe l’impronta ecologica dei datacenter, che consumeranno meno energia;

- aumenterebbe considerevolmente la velocità dell’accesso a internet, delle applicazioni, e in generale di tutte le funzionalità dei laptop;

- migliorerebbe il tempo di reazione nei veicoli autonomi e garantirebbe più velocità per l’object detection, particolarmente utile nei contesti di guida autonoma su strada.

L’aumento e il miglioramento delle funzionalità dei device richiede che anche l’industria hardware stia al passo coi tempi, offrendo i mezzi necessari a supportare il meglio che ogni smartphone, tablet o laptop può offrire. L’utilizzo del 5G è uno tra i fattori che richiedono sempre più potenza a loro supporto, che il 7nm e il 5nm non sono più in grado di offrire. Aumentare il numero di transistor su un chip significa renderli più veloci, efficienti e sicuri. I nuovi chip saranno in grado di supportare al meglio elaborazioni nel mondo dell’intelligenza artificiale e del cloud computing, oltre che aprire nuove strade per la sicurezza hardware-enforced e per la cifratura dei dati.