L’AI che avanza grazie ai GENEOs

Intelligenza Artificiale

Al giorno d’oggi l’Intelligenza Artificiale è tutt’intorno a noi, quasi in tutte le cose che facciamo, dal forno alla lavatrice. Tutti gli strumenti della nostra vita diventano ogni giorno più smart. Basti pensare che il tiratore più forte del mondo è proprio un’Intelligenza Artificiale, o ancora che ne esiste una in grado di individuare i virus pericolosi per l’uomo. Nonostante l’AI sià già così avanti da un punto di vista tecnologico, potrebbe avanzare ancora grazie ad i GENEOs.

Proprio grazie a quattro ricercatori italiani, di diversi istituti di ricerca, si sta insegnando alle macchine a riconoscere immagini complesse, proprio come fossero umani. In particolare, i quattro ricercatori, Mattia G. Bergomi del Champalimaud Center for the Unknown di Lisbona, Patrizio Frosini dell’ Advanced Research Center on Electronic Systems “Ercole de Castro” dell’Università di Bologna, Daniela Giorgi dell’ Istituto di scienze e tecnologie dell’informazione “Alessandro Faedo” del Cnr di Pisa e Nicola Quercioli del Dipartimento di Matematica dell’Università di Bologna, hanno condotto una ricerca sull’utilizzo dei GENEOs per l’AI, e proprio grazie a loro, si riescono a rielaborare le informazioni percepite da questi studi.

Cosa sono i GENEOs e come funzionano nel campo dell’AI

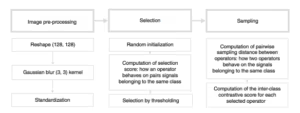

I GENEOs o Group Equivariant Non-Expansive Operators sono degli operatori che fungono da mappe in grado di filtrare e trasformare le operazioni, e possono essere combinati in reti complesse. Il tutto quindi si basa su una teoria matematica che permette di estrarre le informazioni più significative a partire da tutte quelle disponibili. Il compito di questi operatori è quindi proprio quello di rendere più efficienti l’elaborazione dei dati. La ricerca è stata pubblicata sulla rivista Nature Machine Intelligence.

I ricercatori hanno messo alla prova il loro modello “insegnando” ad una rete neurale a riconoscere delle cifre scritte a mano, magari da persone diverse. Questo è un compito che può sembrare quasi “inutile” oltre che “molto semplice”, ma per un computer non è cosi. Un computer potrebbe interpretare molto facilmente come stessa cifra la scrittura di due cifre diverse, così come potrebbe interpretare la stessa cifra scritta con due grafie diverse come diversa.

L’insegnamento è stato applicato in modo che venisse forzato l’apprendimento da parte della macchina. Grazie a questa forzatura è stato fatto si che la macchina riconoscesse solo i tratti caratteristici dell’immagine, tralasciando quelli non importanti ai fini del riconoscimento della cifra. Grazie a questo approccio il tempo necessario per distinguere due cifre si è abbassato notevolmente, permettendo alla macchina di apprendere in modo più veloce e di riconoscere in modo più efficiente.

Questi sistemi sono in grado di produrre sintesi significative di grandi basi di dati e si spera possano arrivare in futuro a riconoscere somiglianze tra due forme con la stessa abilità di un essere umano: una capacità che potrebbe essere applicata, per esempio, per interpretare in modo corretto i sintomi di una malattia

P. Frosini